- Teknologi prompt caching dari Anthropic dapat menghemat biaya pengembang.

- Prompt caching dari Anthropic memungkinkan model mengingat konteks antara panggilan API.

- Teknologi caching prompt dari Anthropic dapat meningkatkan kecepatan respons model.

pibitek.biz -Anthropic baru saja merilis teknologi prompt caching pada API-nya. Teknologi ini memungkinkan model untuk mengingat konteks antara panggilan API dan menghindari pengulangan prompt. Fitur ini sudah tersedia dalam versi beta publik pada Claude 3.5 Sonnet dan Claude 3 Haiku, namun dukungan untuk model Claude terbesar, Opus, masih dalam tahap pengembangan.

2 – Startup AI Perplexity Bidik Pendanaan 7 Triliun 2 – Startup AI Perplexity Bidik Pendanaan 7 Triliun

3 – Fitur Canvas ChatGPT Tampilkan Perubahan Teks 3 – Fitur Canvas ChatGPT Tampilkan Perubahan Teks

Teknologi prompt caching memungkinkan pengguna untuk menyimpan konteks yang sering digunakan dalam sesi mereka. Dengan demikian, pengguna dapat menambahkan informasi latar belakang tambahan tanpa meningkatkan biaya. Fitur ini sangat berguna dalam kasus-kasus di mana seseorang ingin mengirimkan sejumlah besar konteks dalam prompt dan kemudian merujuk kembali ke konteks tersebut dalam percakapan yang berbeda dengan model. Fitur ini juga memungkinkan pengembang dan pengguna lain untuk memperbaiki respons model dengan lebih baik.

Anthropic menyatakan bahwa pengguna awal telah melihat peningkatan kecepatan dan biaya yang signifikan dengan menggunakan teknologi prompt caching untuk berbagai kasus penggunaan, mulai dari menyertakan basis pengetahuan lengkap hingga contoh 100-shot dan menyertakan setiap putaran percakapan dalam prompt. Perusahaan tersebut juga menyatakan bahwa kasus penggunaan potensial termasuk mengurangi biaya dan latensi untuk instruksi panjang dan dokumen yang diunggah untuk agen percakapan, autocompletion kode yang lebih cepat, memberikan instruksi multiple kepada alat pencarian agen, dan menyertakan dokumen lengkap dalam prompt.

Salah satu keuntungan dari teknologi prompt caching adalah harga per token yang lebih rendah. Anthropic menyatakan bahwa menggunakan prompt yang disimpan dalam cache "jauh lebih murah" daripada harga token input dasar. Untuk Claude 3.5 Sonnet, menulis prompt untuk disimpan dalam cache akan dikenakan biaya $3,75 per 1 juta token (MTok), namun menggunakan prompt yang disimpan dalam cache akan dikenakan biaya $0,30 per MTok. Harga dasar input ke model Claude 3.5 Sonnet adalah $3/MTok, sehingga dengan membayar sedikit lebih banyak di awal, pengguna dapat mengharapkan penghematan 10 kali lipat jika menggunakan prompt yang disimpan dalam cache pada kesempatan berikutnya.

Pengguna Claude 3 Haiku akan dikenakan biaya $0,30/MTok untuk menyimpan prompt dalam cache dan $0,03/MTok saat menggunakan prompt yang disimpan. Namun, seperti yang diperhatikan oleh influencer AI Simon Willison di X, cache Anthropic hanya memiliki umur 5 menit dan diperbarui setiap kali digunakan. Tentu saja, ini bukan pertama kalinya Anthropic mencoba bersaing dengan platform AI lain melalui harga.

Sebelum peluncuran model Claude 3, Anthropic telah memotong harga tokennya. Sekarang, perusahaan tersebut sedang dalam "perlombaan ke bawah" melawan rival seperti Google dan OpenAI dalam menawarkan opsi harga rendah untuk pengembang pihak ketiga yang membangun di atas platformnya. Platform lain juga menawarkan versi caching prompt. Lamina, sistem inferensi LLM, menggunakan caching KV untuk mengurangi biaya GPU.

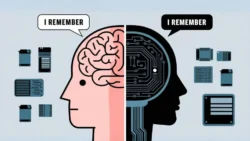

Dengan melihat forum pengembang OpenAI atau GitHub, akan muncul pertanyaan tentang bagaimana cara caching prompt. Caching prompt tidak sama dengan memori LLM. Misalnya, GPT-4o OpenAI menawarkan memori di mana model mengingat preferensi atau detail.

Namun, tidak menyimpan prompt dan respons aktual seperti caching prompt. Dalam beberapa kasus, caching prompt dapat membantu mengurangi biaya dan meningkatkan kecepatan respons model. Namun, perlu diingat bahwa cache hanya memiliki umur 5 menit dan diperbarui setiap kali digunakan.

Dalam beberapa tahun terakhir, teknologi AI telah berkembang pesat, dan perusahaan seperti Anthropic terus berinovasi untuk meningkatkan kinerja dan mengurangi biaya. Dengan teknologi prompt caching, Anthropic berharap dapat membantu pengembang dan pengguna lain untuk memperbaiki respons model dan mengurangi biaya. Dalam beberapa bulan terakhir, Anthropic telah merilis beberapa fitur baru, termasuk model Claude 3 dan teknologi prompt caching. Perusahaan tersebut terus berinvestasi dalam pengembangan teknologi AI dan berharap dapat membantu pengembang dan pengguna lain untuk mencapai tujuan mereka.